作者地址:https://github.com/dataabc/weibo-crawler

更多设置可以进行阅读并修改

项目简介

Weibo Crawler 是一个功能强大的新浪微博爬虫工具,可以持续爬取一个或多个新浪微博用户的数据。它几乎可以获取用户微博的所有数据,包括用户信息和微博内容两大类。

图片

视频

教程开始

一.下载文件

点击右侧侧边栏进行资源下载

二、下载Pycharm和Python

Windows系统

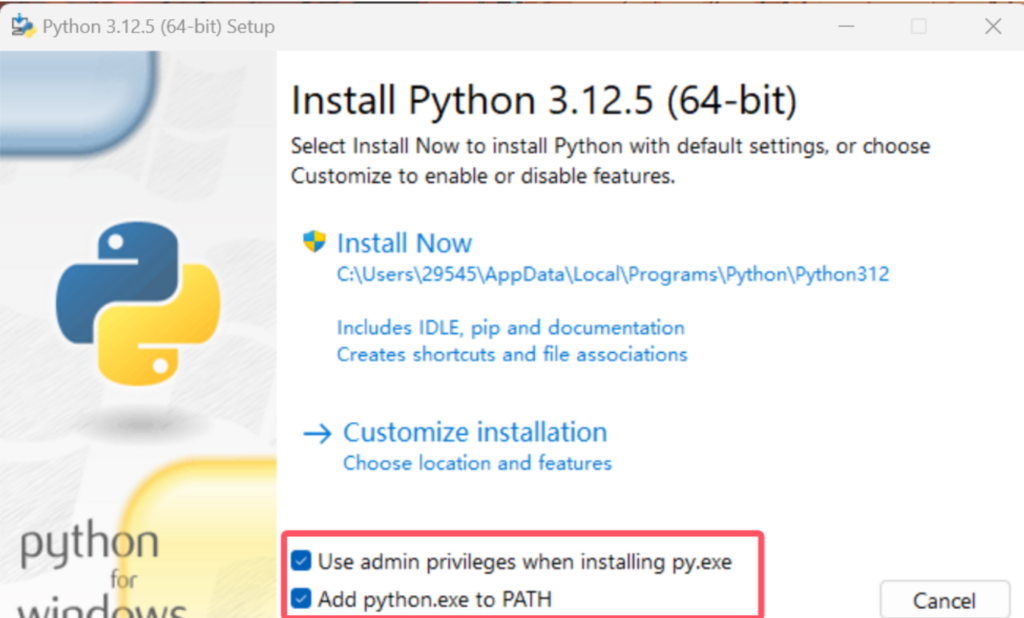

- 访问 Python 官网下载页面:https://www.python.org/downloads/

- 点击”Download Python 3.x.x”下载最新版本

- 运行下载的安装包,重要:勾选”Add Python to PATH”

- 点击”Install Now”开始安装

- 等待安装完成

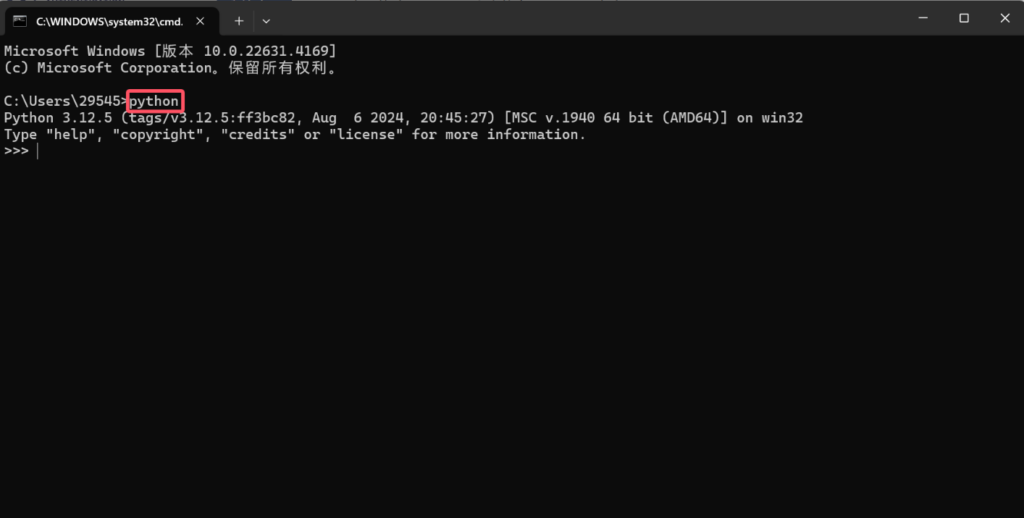

验证安装

- 按 Win+R 打开运行窗口

- 输入 cmd 打开命令提示符

- 输入以下命令验证安装:

python --version

三、Pycharm配置环境

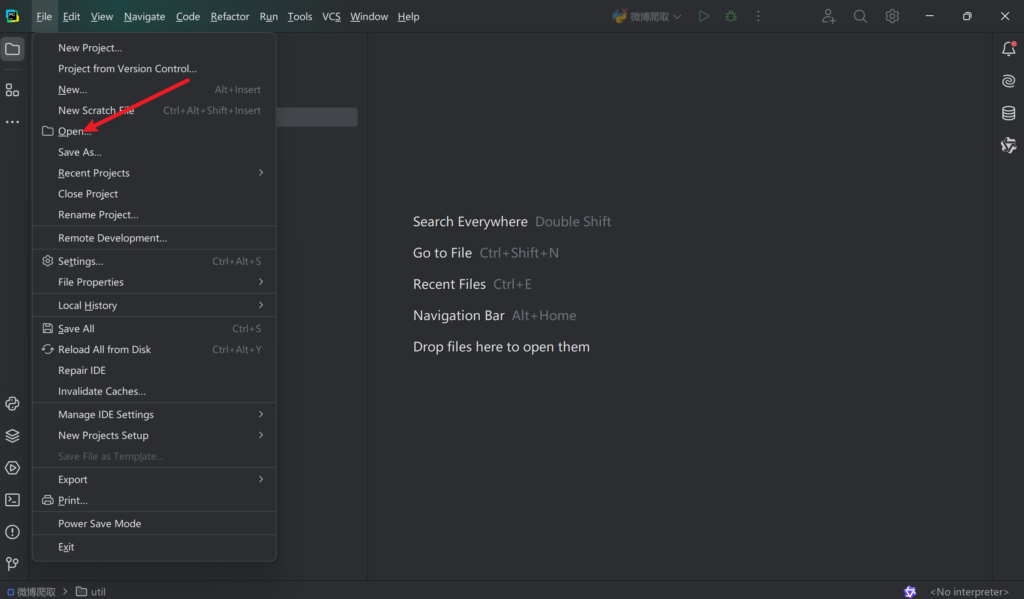

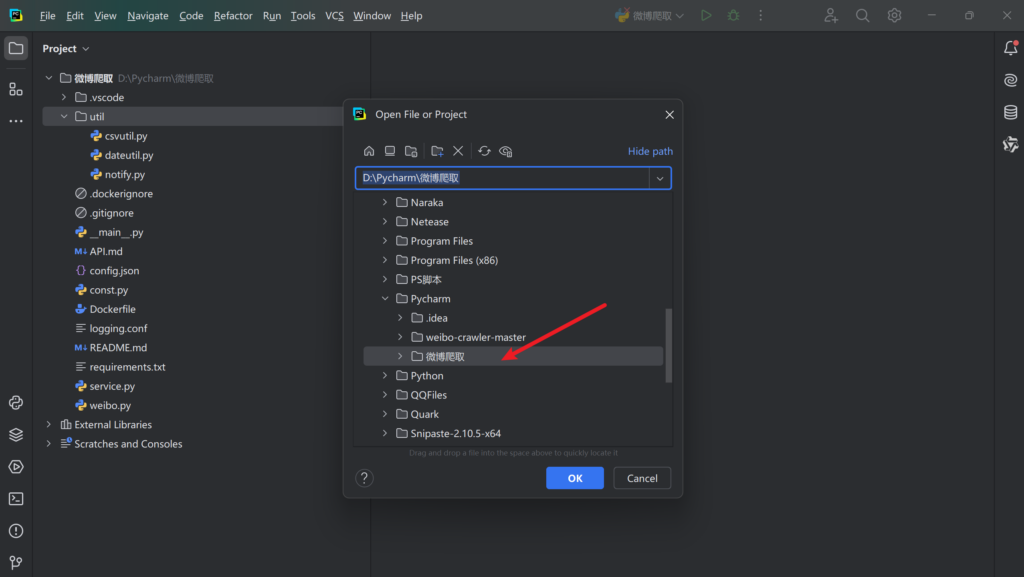

1、打开解压后项目的文件夹

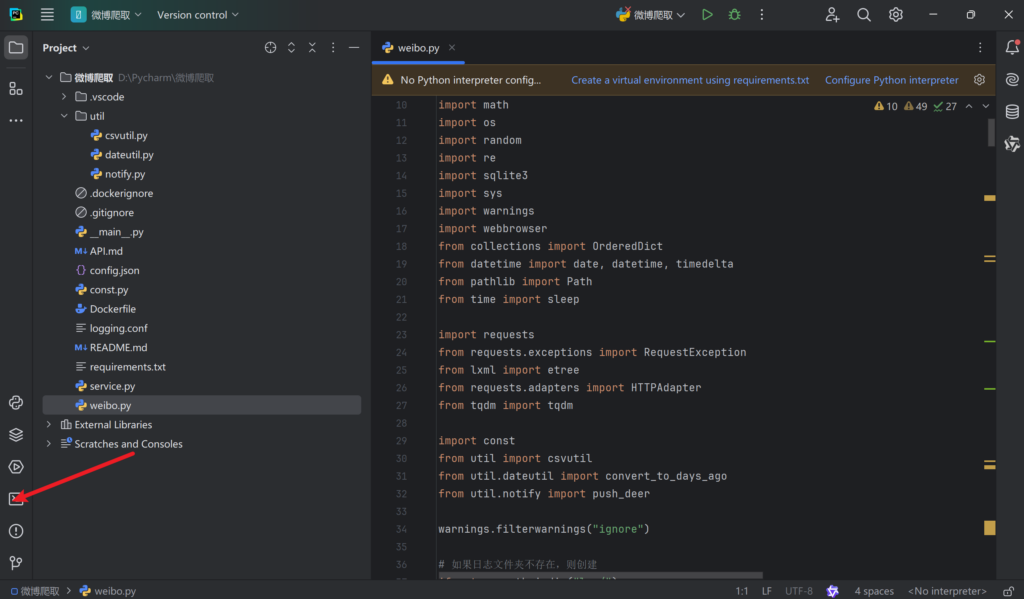

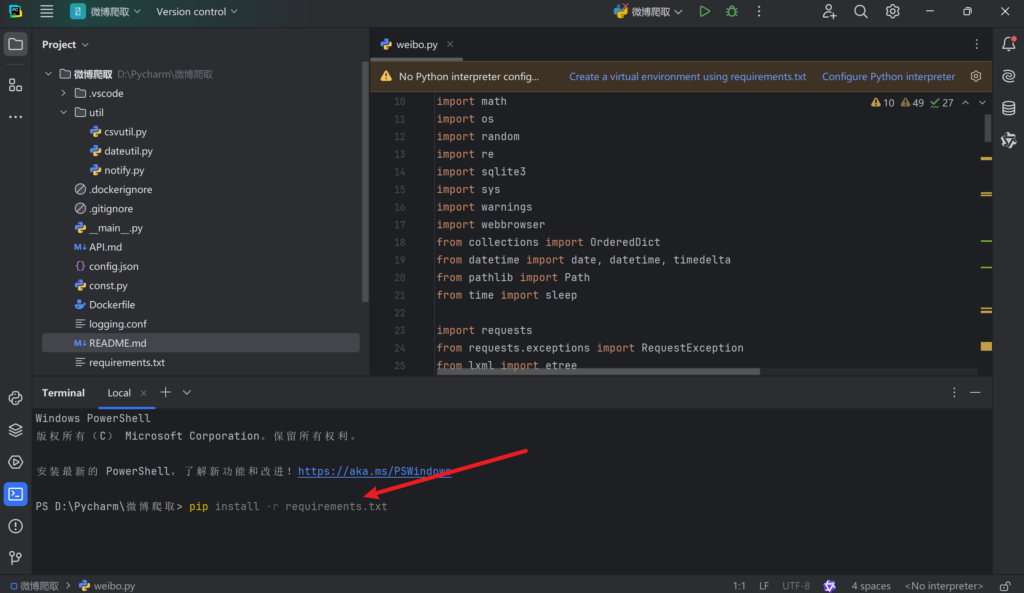

2、安装依赖

- 打开 PyCharm 的终端(Terminal)

- 输入以下命令安装依赖:

pip install -r requirements.txt

3、配置config.json

- 在项目中找到 config.json 文件

- 修改配置:

{

"user_id_list": ["1669879400"], // 替换成你要爬取的用户ID

"since_date": "2023-01-01", // 爬取起始日期

"write_mode": ["csv"], // 结果文件格式

"original_pic_download": 1, // 是否下载图片

"original_video_download": 1, // 是否下载视频

"cookie": "" // 可选:添加cookie

}添加Cookie(可选但推荐)

- 用Chrome打开:https://passport.weibo.cn/signin/login

- 登录微博账号

- 按F12打开开发者工具

- 在地址栏输入:https://weibo.cn

- 在开发者工具中选择:Network -> weibo.cn -> Headers

- 找到”Cookie:”后的值复制到config.json中

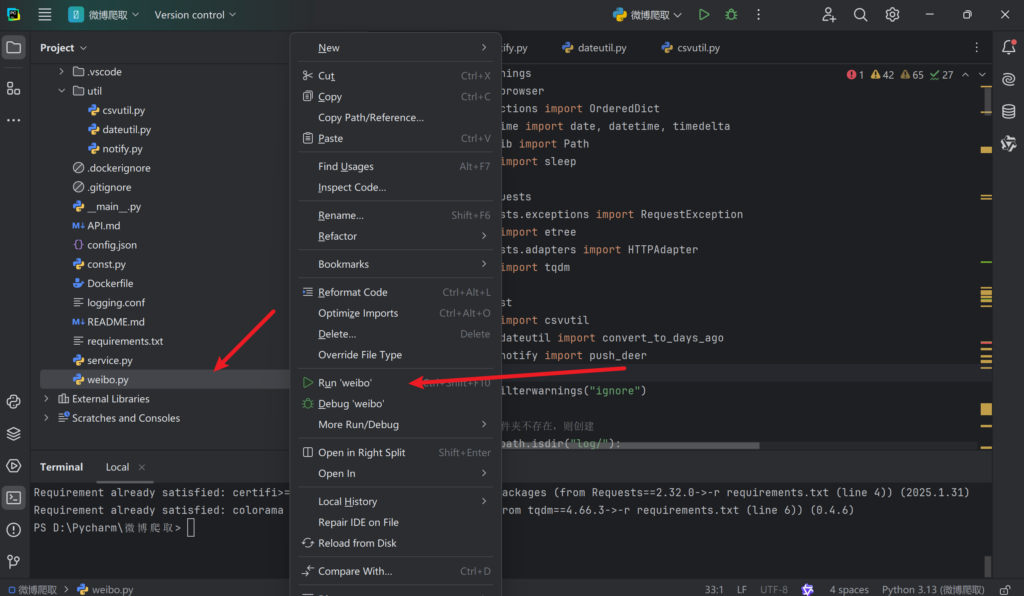

4、配置完成后鼠标右键点击,打开weibo.py,进行运行

详细的config.json配置文件使用教程

config.json 配置完全指南

文件位置

项目根目录下的config.json文件

基础配置模板

{

"user_id_list": ["1669879400"],

"only_crawl_original": 1,

"remove_html_tag": 1,

"since_date": "2023-01-01",

"start_page": 1,

"page_weibo_count": 10,

"write_mode": ["csv"],

"original_pic_download": 1,

"retweet_pic_download": 0,

"original_video_download": 1,

"retweet_video_download": 0,

"download_comment": 1,

"comment_max_download_count": 1000,

"download_repost": 1,

"repost_max_download_count": 1000,

"user_id_as_folder_name": 0,

"cookie": "your_cookie_here",

"mysql_config": {

"host": "localhost",

"port": 3306,

"user": "root",

"password": "123456",

"charset": "utf8mb4"

},

"mongodb_URI": "mongodb://user:pass@host:port/dbname",

"post_config": {

"api_url": "https://api.example.com",

"api_token": "your_token"

}

}配置项详解

1. 用户相关配置

"user_id_list": ["1669879400", "1223178222"]- 作用:指定要爬取的微博用户ID

- 格式:

- 直接填写ID数组:

["ID1", "ID2"] - 使用txt文件:

"user_id_list.txt" - 获取方法:

- 访问用户微博主页

- 查看地址栏URL格式:

https://weibo.cn/用户ID/info

2. 爬取范围控制

"only_crawl_original": 1- 取值:

1:仅爬取原创微博0:爬取全部微博(原创+转发)

"since_date": "2023-01-01"- 格式:

- 具体日期:

"YYYY-MM-DD" - 最近天数:

30(爬取最近30天的微博)

3. 内容处理配置

"remove_html_tag": 1- 作用:是否清除微博内容中的HTML标签

- 取值:

1:清除(推荐)0:保留原始格式

4. 分页设置

"start_page": 1,

"page_weibo_count": 10- start_page:起始页码(从1开始)

- page_weibo_count:每页爬取微博数(1-100)

5. 输出配置

"write_mode": ["csv", "mysql", "mongodb"]- 可选值:

csv:生成CSV文件json:生成JSON文件mysql:写入MySQL数据库mongodb:写入MongoDBsqlite:写入SQLitepost:通过API发送

6. 媒体下载配置

| 配置项 | 说明 | 取值 |

|---|---|---|

original_pic_download | 下载原创微博图片 | 0/1 |

retweet_pic_download | 下载转发微博图片 | 0/1 |

original_video_download | 下载原创视频 | 0/1 |

retweet_video_download | 下载转发视频 | 0/1 |

7. 评论/转发配置

"download_comment": 1,

"comment_max_download_count": 1000,

"download_repost": 1,

"repost_max_download_count": 1000- 仅当

write_mode包含sqlite时生效

8. 高级配置

"user_id_as_folder_name": 0- 作用:文件夹命名方式

0:使用用户昵称1:使用用户ID

"cookie": "SUB=_2AkMT..."- 获取方法:

- 登录微博网页版

- 按F12打开开发者工具

- 查看Network请求头中的Cookie值

数据库配置示例

MySQL配置

"mysql_config": {

"host": "localhost",

"port": 3306,

"user": "weibo_user",

"password": "secure_password",

"charset": "utf8mb4"

}- 需提前创建数据库:

CREATE DATABASE weibo DEFAULT CHARACTER SET utf8mb4;MongoDB配置

"mongodb_URI": "mongodb://user:pass@127.0.0.1:27017/weibo"完整配置示例

{

"user_id_list": ["1669879400", "1223178222"],

"only_crawl_original": 0,

"remove_html_tag": 1,

"since_date": 30,

"write_mode": ["csv", "mysql"],

"original_pic_download": 1,

"retweet_pic_download": 1,

"original_video_download": 1,

"retweet_video_download": 0,

"cookie": "SUB=_2AkMT...",

"mysql_config": {

"host": "localhost",

"port": 3306,

"user": "weibo_user",

"password": "secure_password",

"charset": "utf8mb4"

}

}注意事项

- JSON文件必须使用双引号

- 参数值类型需正确(数字不加引号,字符串加引号)

- 每次修改配置后需重启爬虫程序

- 建议定期备份配置文件

- 使用数据库时需要提前创建对应表结构

错误排查

- 配置未生效:检查文件路径和JSON格式

- 数据库连接失败:检查端口、用户名、密码是否正确

- 媒体下载失败:检查网络连接和存储权限

- 部分数据缺失:尝试添加有效Cookie

通过合理配置这些参数,您可以灵活控制爬虫的行为,满足不同的数据采集需求。建议初次使用时先进行小规模测试,确认配置正确后再进行完整爬取。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

暂无评论内容